BIBLIOMÉTRIE

L’évaluation des chercheurs : toujours des pairs, mais de plus en plus de chiffres…

En France, les chercheurs (des organismes publics de recherche et enseignants-chercheurs des universités) sont évalués au niveau individuel pour leur recrutement, leur évolution de carrière, leurs demandes de financement et d’équipe.

Classiquement, ces évaluations reposent sur le principe de « l’évaluation par les pairs » : on demande à d’autres chercheurs expérimentés et travaillant dans le même domaine de recherche d’apprécier l’activité scientifique du chercheur, principalement au travers des résultats qu’il a publiés dans des journaux scientifiques. L’évaluation par les pairs repose sur deux éléments centraux : la légitimité scientifique des évaluateurs, la collégialité du processus d’évaluation. Deux difficultés inhérentes à l’exercice sont en effet à prendre en compte : tout d’abord, la difficulté « technique » à apprécier la qualité d’une recherche, puisqu’il s’agit le plus souvent d’un travail original et très spécialisé ; ensuite, la difficulté à s’abstraire de la proximité – ou de la distance – intellectuelle ou professionnelle avec le collègue évalué et à porter sur son activité un jugement équilibré. Des décennies de pratique ont peu à peu permis de mettre au point des règles pour combattre ces dangers : déclaration de conflits d’intérêt, rendu de compte sur les débats, changement régulier d’évaluateurs. Mais elles ont encore accru le principal inconvénient de cette méthode, qui est son coût et sa lourdeur : prendre connaissance du dossier du chercheur, lire ses publications, comprendre le travail dont il rend compte, apprécier le potentiel de cette recherche pour l’avenir, écrire un rapport d’évaluation et débattre en comité sont des processus qui demandent beaucoup du temps.

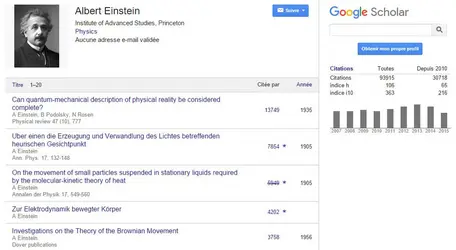

C’est une des raisons pour lesquelles, au moins dans un certain nombre de disciplines, les comités de pairs s’appuient de plus en plus ouvertement sur des indicateurs. Comme précédemment, ces indicateurs sont fondés sur le recensement du nombre de publications cosignées par le chercheur, sur la « cote » des journaux dans lesquels elles ont été publiées, et sur le nombre de fois où ces publications ont été citées par des confrères en appui de leurs propres travaux. À cet égard, certains indicateurs très prisés pour l’évaluation individuelle, comme le h-index (ou indice h), ne semblent pas devoir supplanter des indicateurs simples et robustes qui peuvent être étalonnés, normalisés, et suivis dans le temps, comme l’impact moyen des articles du chercheur.

L’autre raison pour utiliser ces indicateurs c’est, justement, de limiter l’arbitraire lié au travail des pairs, en introduisant des éléments quantifiés dans leurs débats – éléments que les membres d’un comité d’évaluation sont bien armés pour utiliser, puisqu’ils ont une connaissance fine du contexte de travail du chercheur et qu’ils sont à même de comprendre qu’un même score n’aura pas la même signification selon le moment de la carrière du chercheur, selon la difficulté des thèmes de recherche qu’il aborde, selon que sa recherche est plus ou moins appliquée, selon les infrastructures auxquelles il a accès, etc. Mais les observations faites sur ces évaluations « informées » mettent en évidence un autre danger : celui de la dictature du chiffre. Par exemple, il n’est pas facile, pour un chercheur, de critiquer un collègue en comparaison du travail d’un autre chercheur dont les scores sont « moins bons » numériquement. Ainsi les indicateurs peuvent-ils peser très lourd et, finalement, accroître le conformisme du processus d’évaluation – et ce danger sera d’autant plus grand que les évaluateurs manqueront de temps pour se forger une opinion.

La suite de cet article est accessible aux abonnés

- Des contenus variés, complets et fiables

- Accessible sur tous les écrans

- Pas de publicité

Déjà abonné ? Se connecter

Écrit par

- Ghislaine FILLIATREAU : directrice de recherche à l'Institut national de la santé et de la recherche médicale, ancienne directrice de l'Observatoire des sciences et des techniques du Haut Conseil de l'évaluation de la recherche et de l'enseignement supérieur

Classification

Média