BIG DATA

L’expression « big data », d’origine américaine et apparue en 1997, désigne un volume très important de données numériques ainsi que les techniques et outils informatiques permettant de les manipuler efficacement afin de leur donner du sens. Traduite en français par « mégadonnées » ou encore « données massives », elle évoque avant tout un changement d’échelle radical dans le volume des données à traiter et une modification fondamentale dans la manière de les analyser. Contrairement aux bases de données traditionnelles où la recherche d’information se fait de manière exhaustive à partir de données fortement structurées, le big data exploitedes données souvent déstructurées et bien plus nombreuses afin de déterminer de manière automatisée un modèle mathématique, une loi d’évolution ou une tendance utilisable à des fins prospectives.

Le « big data »est représentatif du monde hyperconnecté dans lequel nous vivons, et s’appuie sur des principes mathématiques et informatiques très avancés : communication sans fil en tout point de la planète, centres de données (data centers) offrant des moyens de calcul parallèle et de stockage à très haute performance... Ses champs d’application sont potentiellement infinis et d’une portée économique inimaginable. Il devient possible de procéder à des analyses prospectives fines pour les sciences, en particulier l’environnement et la météorologie ou encore la gestion des risques. Le plus gros marché du big data concerne néanmoins les utilisations commerciales (assurances, banques), politiques et culturelles pour analyser des phénomènes de masse avec pour objectif de faciliter la prise automatique de décisions.

Ordres de grandeur, changement d’échelle

L’histoire du big data est indissociable de celle des technologies de l’information et de la communication, commencée au milieu du xxe siècle avec l’apparition des premiers ordinateurs réellement exploitables, permettant de stocker de manière fiable et non volatile des quantités importantes de données numériques. L’expression « big data » est quant à elle apparue en 1997, lorsque des scientifiques ont été confrontés pour la première fois à des problèmes de représentation graphique de très gros ensembles de données.

Avec l’essor de l’informatique personnelle au début des années 1980, puis celui d’Internet la décennie suivante, le nombre de données produites par l’homme n’a cessé d’augmenter et les besoins en stockage ont dû suivre avec un rythme soutenu. En 1975, les premiers ordinateurs personnels avaient une capacité mémoire de quelques kilooctets (103 octets), et le premier IBM PC (PC pour personal computer), commercialisé en 1981, disposait d’un mégaoctet (106 octets) de mémoire. Désormais, un ordinateur personnel standard comporte quelques gigaoctets (109 octets) de mémoire vive et un disque dur peut atteindre quelques téraoctets (1012 octets) de capacité.

Si l’on met en regard ces chiffres d’une informatique personnelle avec le nombre d’octets d’information générés chaque année sur toute la planète, le phénomène du big data apparaît dans toute son ampleur, car les ordres de grandeur ne sont plus du tout les mêmes. Une application comme Facebook générait, en 2013, 10 téraoctets de nouvelles donnéespar jour. En 2016, la planète aurait échangé plus de 1,3 zettaoctets (1021 octets) d’information via Internet. Les multiples d’octets intermédiaires – pétaoctets (1015 octets) et exaoctets (1018 octets) – ont donc très vite été insuffisants pour quantifier ce type de mesures. À partir de 2020, le volume de données générées devrait atteindre quelque 40 zettaoctets par an, et la tendance inflationniste n’est pas près de s’arrêter.

La suite de cet article est accessible aux abonnés

- Des contenus variés, complets et fiables

- Accessible sur tous les écrans

- Pas de publicité

Déjà abonné ? Se connecter

Écrit par

- François PÊCHEUX : professeur, Sorbonne université

Classification

Médias

Autres références

-

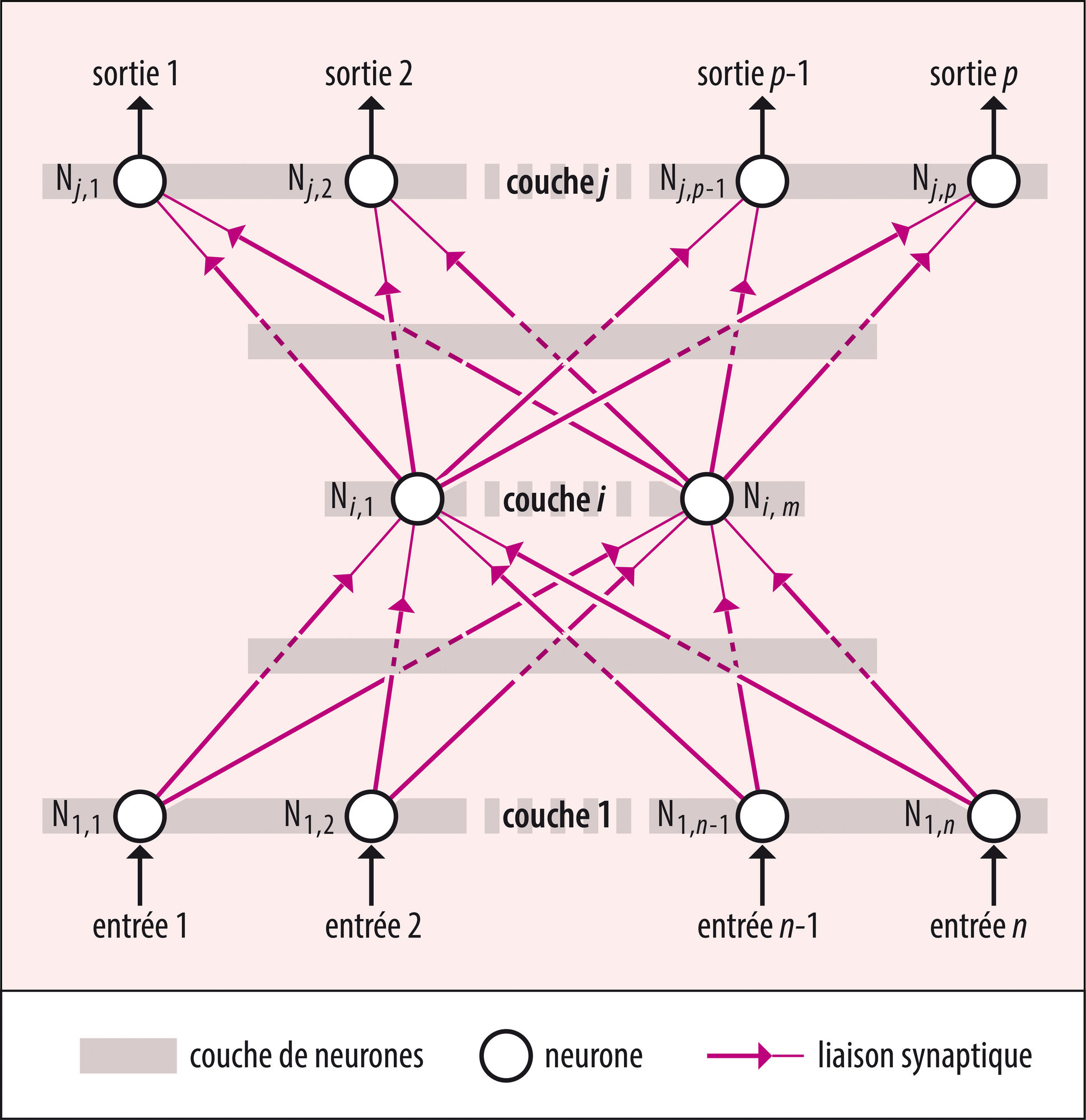

APPRENTISSAGE PROFOND ou DEEP LEARNING

- Écrit par Jean-Gabriel GANASCIA

- 2 646 mots

- 1 média

L’apprentissage supervisé recourt à des techniques variées fondées sur la logique ou la statistique et s’inspirant de modèles psychologiques, physiologiques ou éthologiques. Parmi celles-ci, des techniques anciennes reposant sur un modèle très approximatif du tissu cérébral – les ... -

CARTOGRAPHIE CELLULAIRE DU CERVEAU

- Écrit par Jean-Gaël BARBARA

- 2 990 mots

- 2 médias

big data. Dans tous les cas, l’alignement des bases de données hétérogènes, dynamiques, utilisées et alimentées en ligne en continu, est réalisé en établissant des correspondances entre des ensembles distincts. -

CONSOMMATION - Comportement du consommateur

- Écrit par Bernard DUBOIS et Marc VANHUELE

- 9 032 mots

- 1 média

Par « comportement du consommateur », on entend l'ensemble des comportements qui se rapportent à l'acquisition de biens et services. On y inclut l’exposition à des messages commerciaux et à d’autres types d’information, l'expérience de l’utilisation des biens et services achetés et l'abandon éventuel...

-

HISTOIRE GLOBALE

- Écrit par Pierre-Yves SAUNIER

- 5 933 mots

- 1 média

La montée en puissance des ressources en données massives(big data) et de leur possibilité de traitement approfondit cette fracture méthodologique. Le Collaborative for Historical Information and Analysis (CHIA, fondé en 2011, université de Pittsburgh), le projet Pulotu (Database of Pacific Religions),... - Afficher les 8 références