- 1. Forme et phénomène

- 2. La disjonction transcendantale entre phénoménologie et physique

- 3. La subjectivisation du concept de forme

- 4. Les apories de l'objectivité morphologique

- 5. Éléments de phénophysique

- 6. Le programme de recherche d'une morphodynamique

- 7. Ontologie qualitative et physique du sens

- 8. Bibliographie

FORME

Article modifié le

Éléments de phénophysique

Nous voyons donc que, quelles que soient l'époque et la perspective (métaphysique, psychologique, phénoménologique, objectiviste), la pensée du concept de forme a toujours été fondamentalement limitée par un obstacle épistémologique majeur : l'impossibilité de penser physiquement la phénoménalisation de la matière comme un processus naturel. Le niveau de réalité « écologique », qualitatif, structural et dynamique qu'est le niveau morphologique n'a, répétons-le, jamais réussi à être pensé jusqu'ici comme un niveau de réalité émergent. Pour fixer la terminologie, nous utiliserons le néologisme de « phénophysique » pour ce concept de niveau morphologique émergent du niveau physique. Un peu comme en biologie, le génotype s'exprime dans le phénotype, la physique au sens physicaliste peut être conçue comme une « génophysique » s'exprimant phénoménologiquement – se phénoménalisant – en une phénophysique, en une « phusis phénoménologique ». L'évidence, qui est à l'origine de toutes les apories que nous avons évoquées, est par conséquent qu'il n'existe pas de niveau phénophysique.

Cette évidence a été radicalement remise en cause depuis la fin des années soixante et les physiciens ont élaboré de nombreux éléments de phénophysique.

Caustiques et optique écologique

D'abord, on peut donner raison à Gibson en ce qui concerne l'idée que des discontinuités constitutives de morphologies peuvent être véhiculées par la lumière. Nous considérerons le cas le plus simple, celui des caustiques.

Dans l'approximation de l'optique géométrique dans un milieu homogène et isotrope, les caustiques sont faciles à décrire. Soit S0 une surface émettrice de rayons lumineux, c'est-à-dire un front d'onde initial dans R3 . S0 évolue au cours du temps t parallèlement à lui-même et les rayons sont les droites normales à la famille de ces fronts d'onde St. Ce qui peut rendre la propagation non triviale en introduisant des singularités sur les St est l'existence d'une enveloppe C des rayons. Si elle existe, elle est dite caustique de la propagation. Sur C, l'intensité lumineuse devient « infinie ». Elle diverge dans l'approximation de l'optique géométrique. C'est pourquoi, dans un médium lumineux où l'on a interposé un écran, seules les caustiques sont observables.

L'intérêt des caustiques manifestées est qu'elles sont de pures morphologies. Contrairement aux contours apparents, elles ne sont pas liées à des objets matériels distaux. Et, pourtant, elles fournissent un exemple typique de composantes de l'esquisse 2½-D de Marr. D'origine physique, elles sont également de pures saillances perceptives. Comme l'a remarqué Michael Berry, elles dominent les images optiques et sont phénoménologiquement structurantes. Elles sont donc particulièrement aptes à permettre de tester l'hypothèse d'une optique « écologique ». Or, contrairement à ce qu'on pourrait croire, la physique actuelle donne raison à Gibson.

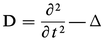

Toute propagation d'ondes lumineuses dans R3 (coordonnées q) est une solution v(q, t) de l'équation des ondes Dv = 0, où D est l'opérateur différentiel hyperbolique :

L'approximation de l' optique géométrique correspond à une longueur d'onde λ = 0, c'est-à-dire à une fréquence τ = ∞. Mais, pour τ = ∞, l'opérateur Dτ n'est plus défini. D'où l'idée de chercher des solutions asymptotiques (relativement à τ), c'est-à-dire des solutions uτ paramétrées par τ, égales à u0 sur S0 et solutions de la famille d'équations perturbées Dτ uτ = ετ, où ετ est une fonction à décroissance rapide en τ. À la limite τ → ∞, u∞ sera alors solution de D∞u∞ = 0. Pour pouvoir retrouver les fronts d'onde St, on les considère comme les surfaces de niveau d'une phase spatiale Φ(q). Φ s'identifie à une longueur de chemin optique régie par un principe variationnel (principe de Fermat). C'est l'analogue d'une action. On cherche en fait des solutions asymptotiques de la forme uτ(q) = aτ(q)eiθ, où θ = τΦ(q) et où l'amplitude aτ(q) admet un développement asymptotique en τ de la forme :

On voit ainsi bien apparaître le lien entre optique géométrique et optique ondulatoire. C'est celui qu'on trouve en général dans les équations aux dérivées partielles hyperboliques ; l'existence d'une infrastructure hamiltonienne (bicaractéristiques, caractéristiques, etc.). À l'opérateur D est associé l'hamiltonien H(q, p) = 1 − | p |2, dit symbole principal de D, sur l'espace de phase T*R3 (fibré cotangent de R3, de coordonnées (q, p)). L'équation caractéristique (eikonale) s'écrit H(q, dΦ) = 0. La métrique euclidienne de R3 établit un isomorphisme canonique entre T*R3 et TR3 (fibré tangent) qui transforme la 1-forme différentielle dΦ dans le champ de vecteurs ∇Φ (d'où la forme 1 − | ∇Φ |2 de l'équation eikonale). Considérons alors le graphe ΛΦ de la 1-forme dΦ (qui comme toutes les 1-formes sur R3 est une section du fibré cotangent T*R3) dans le voisinage U de S0 où Φ est définie. Il est facile de vérifier que pour la structure symplectique canonique de T*R3, définie par la 2-forme fondamentale w = dq ∧ dp (cf. mécanique symplectique) ΛΦ satisfait les trois propriétés suivantes : (1) ΛΦ est une sous-variété lagrangienne de T*U (c'est-à-dire une sous-variété de dimension égale à celle de U et sur laquelle w ≡ 0) ; (2) l'hamiltonien (symbole principal) H s'annule sur ΛΦ ; (3) ΛΦ étant un graphe, il est transverse en tout point aux fibres de la projection canonique π : T*U → U.

Le champ hamiltonien XH défini par H sur T*R3 est donné par les équations canoniques :

L'existence d'une caustique C fait obstruction à la globalisation de Φ car, au-dessus de C, la condition (3) de transversalité n'est plus remplie. D'où l'idée suivante. On appellera solution lagrangienne du problème hamiltonien défini par le symbole principal H une variété lagrangienne Λ sur laquelle H s'annule (conditions (1) et (2)). La caustique C est le contour apparent de Λ. En dehors de C, la condition (3) est remplie et on peut représenter localement Λ comme le graphe d'une solution fonctionnelle Φ. Sur C, ce n'est plus possible.

On peut cependant construire des représentations fonctionnelles locales d'une solution lagrangienne Λ même sur C, au moyen de ce qu'on appelle des intégrales oscillantes. L'idée fondamentale est due à Maslov. On ajoute des variables supplémentaires α = (α1, ... , αp) et, au lieu de chercher des solutions de la forme aτ(q)eiτΦ(q), on cherche des solutions de la forme :

Soient alors Λ une solution lagrangienne de projection π(Λ), Σ le lieu critique de π | ∧ : Λ → R3 et C = π(Σ) la caustique. Si q ∈ π(Λ), les intégrales oscillantes sont à décroissance rapide en τ : R3 − π(Λ) est la zone d'ombre. Si q ∈ π(Λ) − C, les points critiques (α1, ..., αr) de Φq(α) sont non dégénérés. L'intégrale oscillante I(q, τ) est alors approximée par :

On peut montrer que les singularités génériques des caustiques sont identiques aux catastrophes élémentaires. Pour chacune d'elle, il existe une forme normale de leur déploiement universel. On est donc conduit à étudier des intégrales oscillantes particulières : J(y, α) = ∫ f(α) eiτΨ(y, α) dα, où les Ψ(y, α) sont les catastrophes élémentaires. On obtient ainsi des catastrophes de diffraction standard. La photo, due à M. Berry, présente la catastrophe « ombilic elliptique ». On y voit parfaitement la façon dont la géométrie des caustiques – le niveau phéno-physique – émerge de la physique (optique ondulatoire) sous-jacente : l'optique « catastrophiste » fournit un exemple fondateur d'optique « écologique ».

Si l'on analyse soigneusement cet exemple, on remarque qu'il est bien paradigmatique pour une bonne épistémologie de l'émergence.

– On y voit un système naturel organisé à deux niveaux de réalité : un niveau « micro », « fin », « complexe » correspondant à la physique fondamentale du système (géno-physique) et un niveau « macro », « grossier », finiment descriptible et de nature morphologique (phéno-physique).

– Le niveau morphologique « macro » est organisé autour des singularités de la physique sous-jacente. Ces singularités supportent l'information. Elles sont phénoménologiquement dominantes. C'est « l'infrastructure catastrophique » qu'elles constituent qui est prise en charge par la perception.

– On peut lire dans la modélisation mathématique du niveau fin les principes du passage « micro » → « macro », c'est-à-dire du changement de niveau, de l'émergence du phéno-physique (principe de la phase stationnaire et système dynamique hamiltonien associé à l'équation des ondes).

– Il existe des contraintes abstraites et formelles (« platoniciennes »), mathématiquement formulables, imposées au niveau phéno-physique (existence d'un nombre restreint de singularités génériques des caustiques, etc.). Bien qu'émergent, celui-ci possède donc une certaine autonomie et une certaine universalité.

Phénomènes critiques

Lorsqu'on passe de l'optique à la physique des substrats matériels, ces quatre types de considérations peuvent être considérablement généralisés et confirmés. Ils constituent une part essentielle de la physique actuelle.

Considérons par exemple un phénomène critique comme un phénomène de transition de phase. C'est un cas élémentaire d'auto-organisation de la matière puisque, à la traversée d'une valeur critique d'un paramètre de contrôle (la température par exemple), un système physique change brusquement d'état thermodynamique. Ce qui est phénoménologiquement dominant est ici le changement brusque de qualités macroscopiques, c'est-à-dire une discontinuité qualitative. Comment peut-on décrire mathématiquement son émergence à partir de la physique « fine » du système ? Les idées directrices sont les suivantes.

Prenons le cas standard d'une transition du deuxième ordre gouvernée par un phénomène de brisure spontanée de symétrie, à savoir une transition magnétique. On sait qu'au-delà d'une température critique Tc caractéristique (dite point de Curie) un corps ferromagnétique perd son aimantation spontanée et devient paramagnétique. Landau a introduit l'idée qu'on peut décrire en première approximation une telle transition à partir d'un paramètre d'ordre η qui est une variable extensive nulle dans la phase désordonnée (paramagnétique) et non nulle dans la phase ordonnée (ferromagnétique). Cette approximation est l'analogue de celle de l'optique géométrique en optique. Supposons que η soit une densité scalaire η(x) dépendant du point x du substrat W considéré. Thermodynamiquement, le substrat est décrit par la fonction de partition :

F(η) = ∫Wϕ(η) dx est calculée à partir de la densité d'énergie libre ϕ et l'intégrale Z est une intégrale fonctionnelle calculée sur l'espace fonctionnel des η(x). Lorsque le volume V de W tend vers l'infini (ce qu'on appelle la « limite thermodynamique »), les minima ηi de F(η) correspondent à des pics de plus en plus aigus de e-βF(η) et l'intégrale Z = ∫e-βF(η)dη se concentre autour d'eux (principe analogue à celui de la phase stationnaire évoqué plus haut).

L'approximation de Landau consiste alors à négliger les fluctuations autour du point critique T = Tc, à discrétiser et à poser Z = Σie-βF(ηi). Landau suppose en fait d'abord que :

– la densité d'énergie libre ϕ(η) ne dépend des dérivés de η qu'à travers | ∇η |2 (variation quadratique isotrope en les dérivées partielles premières) et Δη (variation linéaire isotrope en les dérivées partielles secondes),

– ϕ dépend de la variable intensive H conjuguée de η (le champ magnétique extérieur) à travers le terme linéaire − Hη.

Si H = 0, la minimisation de F(η) implique ∇η ≡ 0, c'est-à-dire η = constante sur W. Négligeant les fluctuations, Landau suppose alors que l'on peut développer F en série de Taylor au voisinage du point critique T = Tc, η = 0 et écrire F(η) = F0 + αη + Aη2 + Bη3 + Cη4 + ... Des considérations élémentaires sur le comportement phénoménologique de la transition le conduisent alors au modèle standard F = F0 + a (T − Tc)η2 + Cη4 (a > 0, C > 0). C'est le célèbre modèle du cusp en η4 pour le point critique T = Tc, modèle retrouvé sur des bases aprioriques par la théorie des catastrophes (le modèle d'un point tricritique est le modèle en η6 dit du « papillon »).

La théorie de Landau néglige les fluctuations alors que celles-ci sont pourtant dominantes au voisinage du point critique. En ce point, l'énergie libre est singulière et ne peut plus être développée en série de Taylor. Cette limite intrinsèque se manifeste par un grave désaccord entre les prévisions théoriques et les observations expérimentales. Au point critique, le comportement critique du système est caractérisé par les exposants critiques qui expriment la variation des grandeurs thermodynamiques caractéristiques du système comme fonctions de puissances de ΔT = T − Tc ou de η. Les principaux exposants critiques sont :

– ceux du paramètre d'ordre η ∼ ΔTβ, H ∼ ηδ,

– ceux, thermodynamiques, associés à la chaleur spécifique à H constant cH ∼ (ΔT)- α et à la susceptibilité isotherme χT ∼ (ΔT)- γ,

– ceux des fluctuations associés à la longueur de corrélation ξ ∼ (ΔT)- v et à la fonction de corrélation Γ(r) ∼ r2 - d - η (où d est la dimensionnalité du système, r la distance à l'origine et η l'exposant caractéristique et non pas le paramètre d'ordre). Il est facile de voir que l'approximation de Landau implique les valeurs, dites « classiques », β = ½, δ = 3, α = 0, γ = 1, v = ½, η = 0. Or celles-ci ne sont exactes que pour d >− 4 et sont essentiellement inexactes pour d = 2 et d = 3, comme le montrent à la fois les mesures expérimentales et les modèles théoriques résolus mathématiquement ou numériquement.

Mais ces mêmes mesures expérimentales et modèles théoriques ont montré que les phénomènes critiques manifestent pourtant de grandes propriétés d'universalité. Il existe des comportements critiques typiques, très largement indépendants de la physique « fine » des substrats et ne dépendant en fait que de propriétés de symétrie aussi générales et aussi peu « physiques » que, par exemple, la dimension d du système ou celle de η (que nous avons supposé être scalaire par simplicité). Ces comportements critiques typiques et universels appartiennent au niveau phéno-physique. Ils émergent de la physique. Il faut donc développer des méthodes d'approximation qui, tout en n'étant pas aussi dramatiquement grossières que celle de Landau, soient à même de rendre compte de la hiérarchie de degrés d'universalité menant de la température critique (très spécifique du système étudié) aux exposants critiques (très généraux). Le problème est théoriquement et épistémologiquement crucial, car il s'agit de comprendre comment la valeur numérique, quantitativement très précise, des exposants critiques est reliée à des types qualitatifs très généraux de comportements critiques.

Dotés de fortes propriétés d'universalité, les exposants critiques sont, qui plus est, reliés entre eux par un certain nombre d'équations simples, dites lois d'échelle. Les quatre principales lois d'échelles sont :

– la loi de Rushbrooke : α + 2β + γ = 2 ;

– la loi de Widom : γ = β(δ − 1) ;

– la loi de Fisher : γ = (2 − η)v ;

– la loi de Josephson dv = 2 − α.

Une remarque fondamentale à leur sujet est due à Widom : on peut facilement en rendre compte à partir d'hypothèses d'homogénéité affirmant que la partie singulière de l'énergie libre est de la forme :

C'est pour justifier théoriquement la remarque de Widom que Kadanoff introduisit en 1966 l'idée fondamentale du groupe de renormalisation (GR) et de l'invariance d'échelle, idée directrice développée depuis par de nombreux physiciens, en particulier Kenneth Wilson. Le fait physique fondamental manifesté par une transition de phases est celui de l'existence de fluctuations géantes qui, au point critique, deviennent macroscopiques. Au point critique, la longueur caractéristique du système qu'est la longueur de corrélation diverge et le système ne possède donc plus de longueur caractéristique. C'est dire qu'il est invariant par changement d'échelle. D'où l'idée de considérer le point critique comme un point fixe pour des transformations d'échelles.

Plus précisément, on va considérer des modèles discrets ou des modèles continus pour les systèmes envisagés. Les modèles discrets sont le plus souvent des modèles où l'on se donne des spins σiα à n composantes (indexées par α) pouvant prendre un ensemble discret {1, 2, ..., q} ou continu de valeurs, spins distribués aux nœuds d'un réseau de N sites, de symétrie donnée, dans un espace ambiant de dimension d. Si on suppose alors que chaque spin n'interagit qu'avec les spins d'un certain de ses voisinages (interactions à courte portée) et si Jijαβ est la constante de couplage des composantes α et β des spins de deux sites voisins i et j, alors, pour une distribution σ = {σiα} donnée, toute la physique du système en présence d'un champ magnétique extérieur H est contenue dans l'hamiltonien :

À partir de Z, on peut (mécanique statistique standard) retrouver toutes les grandeurs thermodynamiques et toutes les moyennes, corrélations, etc. Dans les modèles continus – qui sont analogues à ceux qu'on trouve en théorie quantique des champs –, on considère des hamiltoniens comme ceux que nous avons déjà rencontrés chez Landau (mais avant l'approximation). Par exemple, η(x) étant la densité de spins :

C'est à ce type de modèle qu'on va chercher à appliquer la stratégie suivante. On va utiliser la propriété d'invariance d'échelle et d'absence de longueur caractéristique au point critique pour réduire drastiquement le nombre de degrés de liberté du système. Considérons, par exemple, un réseau de spins de maille a. Près de la température critique Tc, la longueur de corrélation ξ devient macroscopique par rapport à la maille a : ξ ⪢ a. Ce sont donc les fluctuations à « longue » longueur d'onde qui sont massivement dominantes, et on peut, par conséquent, chercher à éliminer les fluctuations à « courte » longueur d'onde. Pour cela, selon l'idée de Kadanoff, on remplace les spins par des blocs de spins de longueur l avec ξ ⪢ l ⪢ a, chaque bloc ayant pour spin la moyenne des spins (fortement intercorrélés) qui y appartiennent. On renormalise alors la maille du nouveau réseau de façon à la rendre égale à la maille initiale. Le moyennage réduit le nombre de degrés de liberté, ce qui transforme le problème donné en un problème de longueur de corrélation réduite ξ′ < ξ.

Soit alors s le changement d'échelle des longueurs nécessaire pour renormaliser la maille du réseau. Les opérations décrites intuitivement ci-dessus sont a priori exprimables par un opérateur Rs, dit opérateur de renormalisation, agissant sur la fonction F décrivant le système : son hamiltonien, son énergie libre ou sa fonction de partition. Il est clair que ces opérateurs constituent un semi-groupe : Rt ∘ Rs = Rs+t, et on obtient ainsi un (semi)-groupe de transformations sur l'espace fonctionnel F des fonctions F.

Au point critique, la longueur ξ diverge, et cela signifie (puisque ξ/s = ξ) que F est un point fixe des Rs. On est donc conduit à un schéma général tout à fait analogue à celui des systèmes dynamiques (mais d'une difficulté redoutable à mettre effectivement en pratique à cause de très nombreux points techniques d'analyse fonctionnelle). Supposons qu'on prenne, par exemple, pour F l'hamiltonien H du système. Soit H l'espace fonctionnel des hamiltoniens. La première approximation (exacte dans certains cas pas trop complexes) consiste à supposer que tous les hamiltoniens obtenus par renormalisation à partir de l'hamiltonien initial Ho appartiennent à une même classe de H ne dépendant que d'un nombre fini de paramètre (p1, ..., pl) (température T, champ extérieur H, constantes de couplage, etc.) parcourant une sous-variété P de H. Cela permet, en se situant dans P, de ramener le problème à un problème de dimension finie.

Pour un système donné, l'hamiltonien H(T) va décrire, lorsque T décroît à partir des valeurs T > Tc, une courbe de P appelée ligne physique. Comme ξ croît lorsque T décroît vers Tc et diverge pour T = Tc, cette ligne physique est transverse aux hypersurfaces iso-ξ (où ξ = constante) Sξ de P et traverse S∞ en Hc = H(Tc). Appliquons alors le GR. Si H appartient à la ligne physique mais H ≠ Hc(H ∉ S∞), alors la trajectoire de H, sous l'action de GR, s'écarte de S∞ (car GR contracte ξ). Mais, en revanche, la trajectoire de Hc demeure dans S∞.

On est ainsi conduit à analyser la « dynamique » induite par le GR dans S∞. Si la situation est simple, S∞ sera décomposée en bassins d'attraction de différents points fixes et Hc sera « capturé » en général par un tel point fixe H* (à moins qu'il ne se situe sur une séparatrice). L'idée de base est que tous les systèmes dont le Hc appartient à un même bassin B(H*) ont même comportement critique. La position de Hc dans B(H*), Hc pouvant être plus ou moins proche de H*, exprime l'extension du domaine des paramètres sur lequel le système possède le comportement H*. Mais le comportement au point critique (et non plus à son voisinage) ne dépend que de H*. On trouve là une interprétation dynamique remarquablement élégante de ce mixte de quantitatif et de qualitatif que devait a priori présenter la méthode du GR pour pouvoir rendre compte de l'universalité des phénomènes critiques : l'universalité correspond à H* et la spécificité à la position de Hc dans B(H*).

Soit donc H* un point fixe du GR dans S∞ et supposons que les Rs soient linéarisables au voisinage de H*. On a donc Rs(H* + δH) = H* + Ls(δH), où Ls est un opérateur linéaire. Soient Ai les vecteurs propres de Ls et λi(s) les valeurs propres associées. D'après la loi de semi-groupe Rt ∘ Rs = Rs+t, on a λi(s)λi(t) = λi(st) et donc λi = sαi. Si l'on écrit alors que, au voisinage de H*, la fonction F décrivant le système (par exemple l'énergie libre) est une fonction des coordonnées μi associées aux Ai, on en déduit les lois d'homogénéité de F et donc les lois d'échelle. Par exemple, on a F′ = sdF, et donc F(sαiμi) = sdF(μi). On a de même :

Cette image dynamique permet de penser très élégamment un grand nombre de phénomènes. Donnons quelques exemples :

– Si le point Hc où la ligne physique traverse l'hypersurface S∞ appartient à un bassin B(H*), alors on est en présence d'un point critique (de type H*).

– Si Hc traverse S∞ sur une séparatrice, alors on est en présence d'un point tricritique où s'effectue la transition entre deux régimes critiques différents.

– Les trajectoires s'éloignant à l'infini dans S∞ correspondent aux transitions du premier ordre.

– Dans les phénomènes dits de cross-over, un système présente une succession de deux régimes critiques, l'un transitoire et l'autre effectif.

– Les valeurs classiques des exposants critiques correspondent à un point fixe G, dit point gaussien. Ce point est le plus stable pour d > 4. S'il existe des valeurs non classiques, c'est « tout simplement » parce que, à la traversée de la valeur d = 4 de la dimensionnalité du système, le point gaussien G devient instable et se trouve « supplanté » par un point fixe non gaussien NG. Pour d = 4, G et NG coïncident, il y a coalescence de deux régimes critiques, et le champ pertinent assurant l'échange de stabilité entre N et NG devient marginal.

– Mais la théorie qualitative des systèmes dynamiques montre que même des systèmes simples peuvent avoir, s'ils sont non linéaires, des trajectoires très complexes, voire chaotiques. Il semble que cela soit le cas pour certains phénomènes de transition de phases.

Évidemment, toute l'affaire est d'arriver à des formules (approchées) pour le GR. Mais, quoi qu'il en soit, il est crucial de noter que la méthode du GR « conduit à une description géométrique, topologique, des phénomènes critiques », ce qui permet « la transformation d'un problème singulier en un problème régulier dans un espace abstrait » (Toulouse-Pfeuty, 1975). Les difficultés rencontrées sont vraiment considérables (pour une introduction rudimentaire, cf. Petitot, 1986 ; pour des précisions, cf. Toulouse-Pfeuty, 1975, Domb-Green, 1972, Le Bellac, 1988). Mais, malgré elles, on voit bien comment la physique fondamentale permet de comprendre l'apparition de singularités structurant morphologiquement la matière.

Accédez à l'intégralité de nos articles

- Des contenus variés, complets et fiables

- Accessible sur tous les écrans

- Pas de publicité

Déjà abonné ? Se connecter

Écrit par

- Jean PETITOT : ancien élève de l'Ecole polytechnique, docteur es lettres et sciences humaines, vice président de l'International Association for Semiotic Studies, directeur d'études à l'Ecole des hautes études en sciences sociales.

Classification

Autres références

-

ACOUSMATIQUE MUSIQUE

- Écrit par François BAYLE

- 7 825 mots

- 5 médias

...chez René Thom, qui d'ailleurs a cité volontiers ce sémiologue du xixe siècle, précurseur d'une conception qualitative du monde : « Les phénomènes qui sont l'objet d'une discipline [...] apparaissent comme des accidents de formes définis dans l'espace substrat de... -

CRASSET MATALI (1965- )

- Écrit par Christine COLIN

- 928 mots

À ce temps « réel » fait écho un lieu qui ne l'est pas : « La forme est une plate-forme » déclare Matali Crasset. Si on place cette phrase dans la continuité des célèbres aphorismes qui ont véhiculé les théories du design au cours des deux siècles derniers, tels que « l'outil crée la forme... -

DESCRIPTION ET EXPLICATION

- Écrit par Jean LARGEAULT

- 9 391 mots

- 1 média

...d'effet qui en soit distinct, on pourrait seulement parler de son déploiement dans le temps. Aristote et saint Thomas n'assignent pas d'efficace à la forme seule. La forme n'agit pas ; c'est une substance qui agit par sa forme ou suivant sa forme. De même pour Leibniz et Euler, les principes d'optimum... -

DESIGN

- Écrit par Christine COLIN

- 8 028 mots

- 1 média

...théories élaborées par des praticiens. Les aphorismes, ces théories abrégées véhiculées par ces derniers, en permettent un rapide survol. « L'outil crée la forme » peut être considéré comme un héritage du rationalisme du xixe siècle ; « la forme suit la fonction », attribué à l'architecte américain... - Afficher les 29 références

Voir aussi

- CYBERNÉTIQUE

- ONDE DE CHOC

- PROPAGATION DES ONDES

- VARIABLES INTENSIVES

- IMAGES OPTIQUES

- OPTIQUE GÉOMÉTRIQUE

- PHASE TRANSITIONS DE

- HAMILTONIEN

- SYMPLECTIQUE FORMALISME

- ÉTAT CHANGEMENT D'

- REPRÉSENTATION & CONNAISSANCE

- POINT CRITIQUE

- VARIABLES EXTENSIVES

- STRUCTURE, biologie

- HYDRODYNAMIQUE

- OBJECTIVITÉ

- MORPHOGENÈSE VÉGÉTALE

- TOPOLOGIE ALGÉBRIQUE

- ESPACE FONCTIONNEL

- DÉFAUTS, cristallographie

- SMECTIQUE ÉTAT

- TRAJECTOIRE, mathématiques

- SOLIPSISME

- SIGNIFICATION

- ÉPOCHÈ, philosophie

- DISCONTINUITÉ, physique

- PHYSIQUE MATHÉMATIQUE

- ENTÉLÉCHIE

- NOÈME & NOÈSE

- FODOR JERRY ALAN (1935-2017)

- STABILITÉ, analyse numérique

- PARTITION FONCTION DE

- SOUS-VARIÉTÉ, mathématiques

- LIAPOUNOV MÉTHODE DE

- MODÈLE, biologie

- MODÈLE, physique

- QUALITÉS SENSIBLES

- DIFFÉRENCIATION CELLULAIRE ou CYTODIFFÉRENCIATION

- MORPHOLOGIE, biologie

- GÉNÉTIQUE MOLÉCULAIRE

- EIDÉTIQUE

- SYSTÈMES DYNAMIQUES DIFFÉRENTIABLES

- PERTURBATION, mathématiques

- PHASE STATIONNAIRE MÉTHODE DE LA

- GROUPE DE RENORMALISATION

- ATTRACTEUR

- ATTRACTEUR ÉTRANGE

- VARIATIONNELLE FORMULATION

- SYSTÈMES BIOLOGIQUES & BIOCHIMIQUES

- APPROXIMATION

- IMAGES TRAITEMENT D'

- BIFURCATION, mathématiques

- EXPOSANT CRITIQUE

- SYSTÈMES THÉORIE DES

- PERCEPTION VISUELLE

- NÉODARWINISME

- MODÉLISATION

- FLUCTUATION, physique

- RENORMALISATION, physique

- COGNITIVISME

- CONNEXIONNISME

- MARR DAVID (1945-1980)

- TRANSCENDANTAL, philosophie

- GÉNÉRALISATION, logique

- DAUBERT JOHANNES (1877-1947)

- CAUSTIQUES, optique

- ÉCHELLE LOIS D'

- SINGULARITÉS, mathématiques

- ACOUSTIQUE