INTELLIGENCE ARTIFICIELLE GÉNÉRATIVE

Modèles de langage

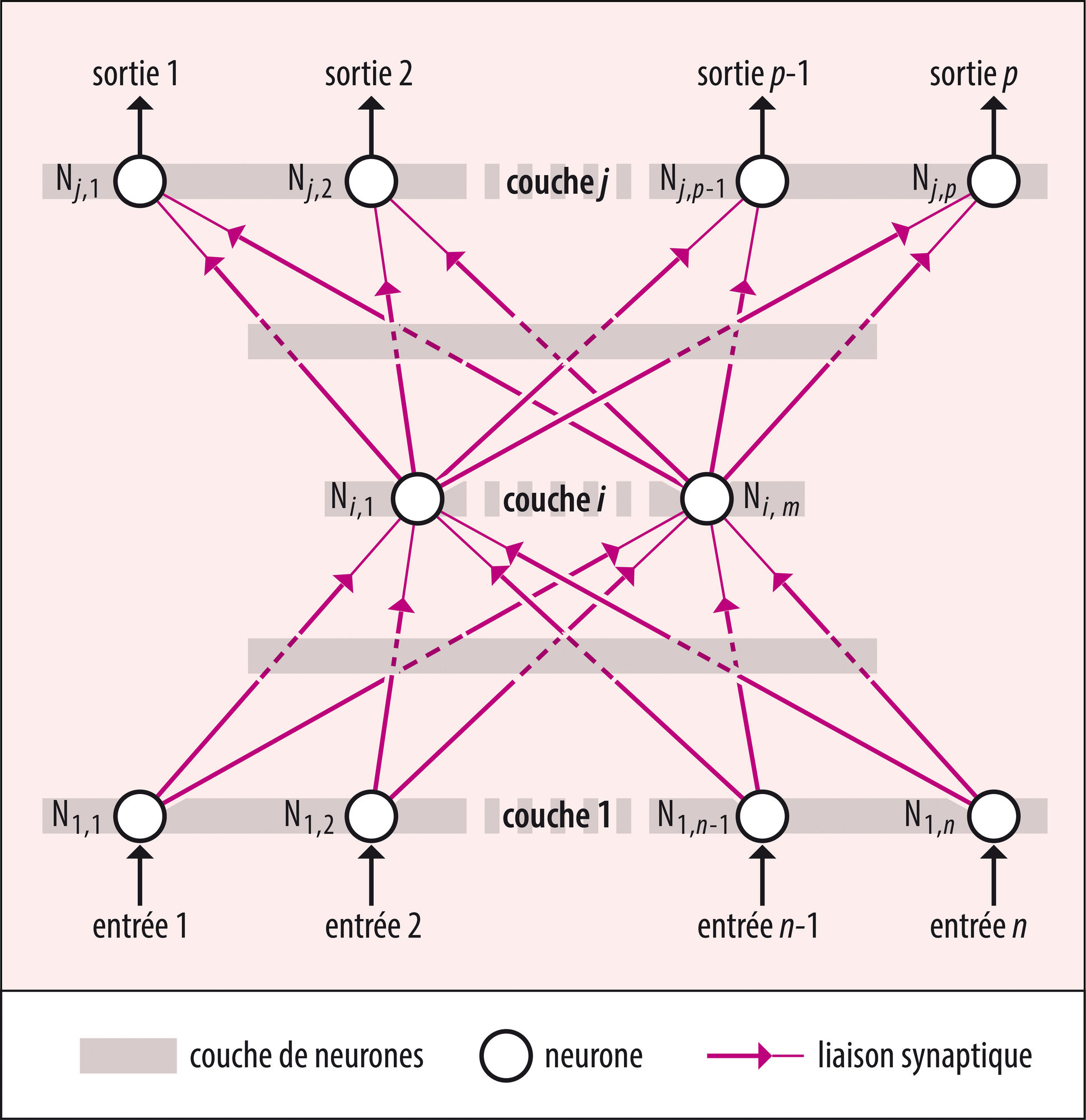

Pour répondre aux besoins du traitement automatique des langues naturelles (TALN), les chercheurs en IA recourent à l’hypothèse dite distributionnelle, selon laquelle le sens des mots provient du contexte dans lequel ils sont employés. On approche ce contexte avec la notion de « plongement lexical » – wordembedding, en anglais –, que l’on représente sous la forme d’un vecteur de taille fixe calculé au moyen de réseaux de neurones formels. Ce dernier établit le lien entre un mot et ses contextes d’apparition. Depuis 2017, les chercheurs des laboratoires de la société Google ont mis en évidence l’utilité des mécanismes dits d’attention pour concevoir des techniques efficaces de calcul des plongements lexicaux que l’on appelle les « transformeurs » (A. Vaswani et al., 2017). Ceux-ci ont donné naissance aux grands modèles de langage comme BERT (Bidirectional Encoder Representations from Transformers) ou GPT (Generative Pretrained Transformer), qui comprennent des centaines de milliards de paramètres et que l’on entraîne sur l’équivalent de centaines de milliers d’ouvrages.

Ces modèles aident à perfectionner la plupart des techniques du TALN comme le résumé de textes, la fabrication de systèmes dits de question/réponse ou la génération automatique de textes par anticipation statistique du mot le plus probable. Et les mêmes techniques s’appliquent à d’autres textes, comme les programmes écrits dans des langages informatiques.

La suite de cet article est accessible aux abonnés

- Des contenus variés, complets et fiables

- Accessible sur tous les écrans

- Pas de publicité

Déjà abonné ? Se connecter

Écrit par

- Jean-Gabriel GANASCIA : professeur des Universités, faculté des sciences, Sorbonne université, Paris

Classification

Médias

Autres références

-

INTELLIGENCE ARTIFICIELLE (IA)

- Écrit par Jean-Gabriel GANASCIA

- 5 584 mots

- 4 médias

Enfant terrible de l’informatique, l’intelligence artificielle est apparue au milieu des années 1950, soit une dizaine d’années après la fabrication de l’ENIAC (Electronic Numerical Integrator and Computer), premier ordinateur entièrement électronique. À l’origine, elle se proposait de simuler les...

-

APPRENTISSAGE PROFOND ou DEEP LEARNING

- Écrit par Jean-Gabriel GANASCIA

- 2 646 mots

- 1 média

Apprentissage profond, deeplearning en anglais, ou encore « rétropropagation de gradient »… ces termes, quasi synonymes, désignent des techniques d’apprentissage machine (machine learning), une sous-branche de l’intelligence artificielle qui vise à construire automatiquement des connaissances...

-

MOTEURS DE RECHERCHE

- Écrit par Brigitte SIMONNOT

- 4 699 mots

- 2 médias

...la liste des résultats pour résumer les renseignements supposés essentiels : c’est le Knowledge Graph. Une telle fonctionnalité est rendue possible par l’intelligence artificielle générative qui permet de composer des textes ou images à partir de l’analyse d’une importante masse de données.