INTELLIGENCE ARTIFICIELLE (IA)

Article modifié le

Enfant terrible de l’informatique, l’intelligence artificielle est apparue au milieu des années 1950, soit une dizaine d’années après la fabrication de l’ENIAC (Electronic Numerical Integrator and Computer), premier ordinateur entièrement électronique. À l’origine, elle se proposait de simuler les différentes facultés cognitives constitutives de l’intelligence, qu’elle soit humaine ou animale, sur des ordinateurs, en les programmant avec les techniques du traitement de l’information. Au cours du temps, l’intelligence artificielle a régulièrement défrayé la chronique. C’est surtout le cas depuis les années 2010 où, avec l’accroissement prodigieux de la capacité de stockage des processeurs, l’accélération inouïe de leur vitesse de calcul, la réduction de leur coût et leur miniaturisation, elle a pris une place croissante dans nos sociétés. Elle est ainsi devenue à la fois nécessaire, permettant de traiter les immenses quantités d’information, et déconcertante, en ce qu’elle reproduit beaucoup de facultés cognitives humaines, au point que certains s’inquiètent et se demandent ce qui restera en propre à l’homme. De quoi est-elle capable et jusqu’où ira-t-elle ? Telles sont les questions que beaucoup se posent désormais. Pour y répondre, il convient d’abord de bien préciser les significations que recouvre cette notion d’intelligence artificielle.

Quelques jalons historiques

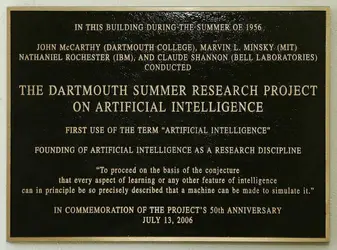

Quelques participants de l’école d’été de Dartmouth (États-Unis)

Photo courtesy of the Minsky family

L’intelligence artificielle est d’abord une discipline scientifique qui a vu officiellement le jour en 1956, au Dartmouth College de Hanover, dans l’État du New Hampshire (États-Unis), lors d’une école d’été organisée par quatre chercheurs américains, John McCarthy (1927-2011), Marvin Minsky (1927-2016), Nathaniel Rochester (1919-2001) et Claude Shannon (1916-2001). Depuis, l'expression « intelligence artificielle », inventée par John McCarthy sans doute pour frapper les esprits, est devenue très populaire au point que plus personne ne l’ignore. Cette composante de l’informatique a pris de plus en plus d’ampleur au fil du temps. Il est vrai que les technologies qui en sont issues ont grandement contribué à changer le monde. À titre d’illustration, le World Wide Web (communément appelé Web), que l’on utilise tous quotidiennement, vient du couplage des réseaux de télécommunication et d’un modèle de mémoire, l’hypertexte, conçu avec des techniques d’intelligence artificielle et publié en 1965 lors d’une conférence sur cette dernière.

Définition et fondement de l’intelligence artificielle

Cinquantième anniversaire de l’école d’été de Dartmouth marquant la naissance de l’Intelligence artificielle

Joseph Mehling/ Courtesy of Dartmouth College Library

Pour les promoteurs de cette école d’été de 1956, l’intelligence artificielle visait initialement à la simulation, sur des machines, de chacune des différentes facultés de l’intelligence, qu’il s’agisse de l’intelligence humaine, animale, végétale ou sociale. Cette discipline scientifique reposait sur la conjecture selon laquelle toutes les fonctions cognitives, en particulier l’apprentissage, le raisonnement, le calcul, la perception, la mémorisation, le langage, voire la découverte scientifique ou la créativité artistique, peuvent être décrites avec une précision telle qu’il serait possible de les reproduire sur des ordinateurs. Par la suite, et en dépit des progrès considérables qu’elle a enregistrés, l’étude de l’intelligence artificielle a toujours reposé sur la même conjecture que rien, jusqu’à présent, n’a permis ni de démentir ni de démontrer irréfutablement.

Quoi que l’on en pense, les indéniables succès que l’intelligence artificielle a remportés en montrent la fécondité. Pour s’en convaincre, rappelons que l’on regroupe souvent les fonctions cognitives en cinq grandes catégories :

– la perception, c’est-à-dire le passage de la sensation, par exemple de l’information visuelle ou sonore, à une représentation en mémoire ;

– la représentation des connaissances,[...]

La suite de cet article est accessible aux abonnés

- Des contenus variés, complets et fiables

- Accessible sur tous les écrans

- Pas de publicité

Déjà abonné ? Se connecter

Écrit par

- Jean-Gabriel GANASCIA : professeur des Universités, faculté des sciences, Sorbonne université, Paris

Classification

Médias

Autres références

-

INTELLIGENCE ARTIFICIELLE GÉNÉRATIVE

- Écrit par Jean-Gabriel GANASCIA

- 2 716 mots

- 2 médias

Le désir de fabriquer des machines capables de générer textes, images et sons, à l’instar d’artistes, remonte bien à avant le développement de l’intelligence artificielle (IA). À titre d’illustration, la Britannique Ada Lovelace (1815-1852) pressentait déjà qu’une machine pourrait,...

-

AGHION PHILIPPE (1956- )

- Écrit par Olivier MARTY

- 1 173 mots

- 1 média

...monde académique, Aghion voit dans celle-ci une source d’efficacité, de profits et donc de développements favorables à l’emploi. À cet égard, il considère l’intelligence artificielle comme une technologie bienvenue que les acteurs économiques ont intérêt à favoriser. De son côté, l’État devrait veiller à... -

ALGORITHME

- Écrit par Thomas SEILLER et Alberto NAIBO

- 5 919 mots

- 4 médias

...imposent une gestion explicite de la mémoire, alors que d’autres non – c’est le cas de Python, l’un des langages les plus employés de nos jours pour le développement d’intelligences artificielles. L’ensemble de ces éléments a mis en exergue l’idée que l’informatique traite de deux notions bien distinctes.... -

ANDERSON JOHN ROBERT (1947- )

- Écrit par Denis ALAMARGOT

- 374 mots

John Robert Anderson est né à Vancouver (Canada) en 1947. Après des études à l’université de la Colombie-Britannique, il obtient son Ph.D. en 1972 à l’université Stanford, sous la direction de G. Bower. D’abord professeur de psychologie à Yale de 1973 à 1977, il rejoint en 1978 l’université Carnegie-Mellon...

-

APPRENTISSAGE, psychologie

- Écrit par Daniel GAONAC'H et Jean-François LE NY

- 5 940 mots

- 2 médias

Ces recherches s’articulent maintenant avec celles qui, enintelligence artificielle, s’appuient sur l’exploitation d’un très grand nombre de données empiriques (big data) : plutôt que d’« instruire » la machine par des règles définies a priori, on cherche à ce que celle-ci se fonde, pour... - Afficher les 41 références

Voir aussi

- PROGRAMME, informatique

- CYBERNÉTIQUE

- INFORMATION, informatique et télécommunications

- WEB ou WORLD WIDE WEB

- REPRÉSENTATION & CONNAISSANCE

- SCIENCES HISTOIRE DES, XXe XXIe s.

- ÉMOTION

- MÉMOIRE, psychologie

- TECHNOLOGIE

- PAROLE

- NEURONE ou CELLULE NERVEUSE

- PERCEPTION, robotique

- APPRENTISSAGE, informatique et robotique

- MÉLANOME

- SEARLE JOHN ROGERS (1932- )

- TECHNIQUES HISTOIRE DES, XXe et XXIe s.

- MATHÉMATIQUES HISTOIRE DES

- MACROMOLÉCULES BIOLOGIQUES

- NEUROSCIENCES

- COGNITIVISME

- CONNEXIONNISME

- PROCESSEUR, informatique

- PHILAE, sonde spatiale

- COMPRÉHENSION, psycholinguistique

- CHATGPT

- AGENT CONVERSATIONNEL ou CHATBOT

- UBER