INFORMATION THÉORIE DE L'

Théorie de Shannon

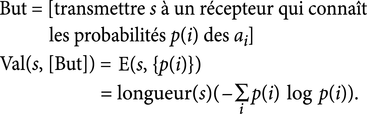

Lorsque le but poursuivi est de transmettre une chaîne de caractère s à un récepteur disposant de la connaissance des fréquences p(i) des lettres de l'alphabet {a1, a2, ..., an}, on définira la valeur en information de s relativement à p(i) et ai, valeur appelée entropie et notée E(s, {p(i)}), par :

Dans cette conception de l'information, on suppose implicitement que le récepteur est capable de faire certains calculs pour reconstituer s à partir de ce qu'on lui transmet. En définitive, la machine M qui fait le décodage peut être prise comme référence et l'on découvre alors que la théorie de Shannon doit être vue comme une version probabiliste de la théorie algorithmique de l'information. On démontre d'ailleurs que le contenu moyen d'information de Kolmogorov des chaînes de caractères s de longueur n, pondérées par les probabilités résultant des fréquences supposées p(i) pour les ai, K(s, {p(i)}) vérifie la relation : |E(s, {p(i)}) – K(s, {p(i)})| < constante.

La théorie de l'information de Shannon est donc aussi une théorie de l'information par compression, qui, au lieu de considérer des suites quelconques, suppose que les suites qu'on transmet vérifient certaines propriétés statistiques. Finalement, la théorie de Shannon est une théorie du contenu en information relativement à un but de compression et à une certaine distribution statistique des suites. Ce n'est donc pas une théorie de l'information limitée au problème de la transmission, comme on le dit parfois.

La théorie de l'information de Shannon est compatible avec celle de Kolmogorov. Chacune a un rôle à jouer et, par exemple, dans la théorie de la mesure et de l'entropie physique de Wojciech Zurek (1989), c'est le jeu complémentaire des deux théories qui est considéré. Pour Zurek, une situation pour laquelle on dispose de peu d'éléments est assimilée à la situation typique dans l'ensemble des situations compatibles avec ce que l'on sait (utilisation de la théorie de Shannon), puis, au fur et à mesure des précisions qu'on acquiert par des mesures, la théorie de Kolmogorov prend le relais et finit par devenir prépondérante.

La suite de cet article est accessible aux abonnés

- Des contenus variés, complets et fiables

- Accessible sur tous les écrans

- Pas de publicité

Déjà abonné ? Se connecter

Écrit par

- Henri ATLAN : professeur émérite de biophysique aux universités de Paris-VI-Pierre-et-Marie-Curie et de Jérusalem, directeur d'études à l'École des hautes études en sciences sociales, Paris, directeur du Centre de recherches en biologie humaine, hôpital Hadassah, Jérusalem (Israël)

- Jean-Paul DELAHAYE : professeur à l'université des sciences et technologies de Lille

- Étienne KLEIN : physicien au Commissariat à l'énergie atomique

Classification

Autres références

-

BRILLOUIN LÉON (1889-1969)

- Écrit par André GUINIER

- 843 mots

Le père et le grand-père de Léon Brillouin ont été professeurs de physique au Collège de France. Après ses études à l'École normale supérieure, il a passé un an auprès de A. Sommerfeld, à Munich. Pendant la Première Guerre mondiale, il est affecté au laboratoire « de T.S.F. » du général Ferrié, où...

-

COGNITION

- Écrit par Chrystel BESCHE-RICHARD et Raymond CAMPAN

- 2 626 mots

...de la cognition a donc ouvert la « boîte noire » à laquelle la psychologie comportementale refusait de s'intéresser. Analyser les phénomènes internes de « traitement de l'information » qui opèrent entre la venue d'un stimulus et la réponse produite par l'individu n'inscrit pas pour autant l'étude de la... -

COGNITIVES SCIENCES

- Écrit par Daniel ANDLER

- 19 265 mots

- 4 médias

L'année décisive est 1956. Au M.I.T., se tient, du 10 au 12 septembre, un « Symposium onInformation Theory » qui marque symboliquement, aux yeux de plusieurs des principaux acteurs, le début d'un nouveau mouvement, intégrant dans une perspective commune la psychologie expérimentale, la... -

COMMUNICATION

- Écrit par Yves WINKIN

- 4 813 mots

...précises. C'est ainsi qu'un groupe de chercheurs se rassemble au Massachusetts Institute of Technology (M.I.T.) autour de Claude Shannon, un spécialiste des théories mathématiques de l'information, pour repenser la transmission télégraphique. Le télégraphe est en effet fondamental en temps de guerre.... - Afficher les 18 références